迁移仓库

This commit is contained in:

commit

27d810c64d

|

|

@ -0,0 +1,6 @@

|

|||

_book

|

||||

node_modules

|

||||

.idea

|

||||

.ropeproject

|

||||

__pycache__

|

||||

env

|

||||

|

|

@ -0,0 +1,8 @@

|

|||

MIT License

|

||||

Copyright (c) <year> <copyright holders>

|

||||

|

||||

Permission is hereby granted, free of charge, to any person obtaining a copy of this software and associated documentation files (the "Software"), to deal in the Software without restriction, including without limitation the rights to use, copy, modify, merge, publish, distribute, sublicense, and/or sell copies of the Software, and to permit persons to whom the Software is furnished to do so, subject to the following conditions:

|

||||

|

||||

The above copyright notice and this permission notice shall be included in all copies or substantial portions of the Software.

|

||||

|

||||

THE SOFTWARE IS PROVIDED "AS IS", WITHOUT WARRANTY OF ANY KIND, EXPRESS OR IMPLIED, INCLUDING BUT NOT LIMITED TO THE WARRANTIES OF MERCHANTABILITY, FITNESS FOR A PARTICULAR PURPOSE AND NONINFRINGEMENT. IN NO EVENT SHALL THE AUTHORS OR COPYRIGHT HOLDERS BE LIABLE FOR ANY CLAIM, DAMAGES OR OTHER LIABILITY, WHETHER IN AN ACTION OF CONTRACT, TORT OR OTHERWISE, ARISING FROM, OUT OF OR IN CONNECTION WITH THE SOFTWARE OR THE USE OR OTHER DEALINGS IN THE SOFTWARE.

|

||||

|

|

@ -0,0 +1,45 @@

|

|||

## 机器学习

|

||||

|

||||

主要用来记录机器学习中遇到的问题及其解决方案

|

||||

|

||||

### 环境搭建

|

||||

执行下面命令

|

||||

```sh

|

||||

pip install numpy scipy statsmodels matplotlib

|

||||

pip install -U scikit-learn nltk

|

||||

apt install python-pandas # pythons使用的是python3-pandas

|

||||

apt install python-matplotlib

|

||||

pip install nltk tornado

|

||||

```

|

||||

docker tensorflow环境搭建

|

||||

```sh

|

||||

docker pull dash00/tensorflow-python3-jupyter

|

||||

# 限制使用内存的大小,防止影响到本机

|

||||

docker run -d --name "tensorflow" -m 4000M --cpus=2 -p 8888:8888 dash00/tensorflow-python3-jupyter

|

||||

```

|

||||

|

||||

docker资源清理

|

||||

```sh

|

||||

docker container prune # 删除所有退出状态的容器

|

||||

docker volume prune # 删除未被使用的数据卷

|

||||

docker image prune # 删除 dangling 或所有未被使用的镜像

|

||||

```

|

||||

|

||||

virtualenv使用

|

||||

```sh

|

||||

sudo apt install virtualenv

|

||||

virtualenv env

|

||||

source ./env/bin/activate

|

||||

```

|

||||

|

||||

### 监督学习

|

||||

#### 分类

|

||||

- 决策树

|

||||

- 临近取样

|

||||

- 支持向量机

|

||||

- 神经网络算法

|

||||

#### 回归

|

||||

|

||||

### 非监督学习

|

||||

|

||||

|

||||

|

|

@ -0,0 +1,32 @@

|

|||

# 目录

|

||||

|

||||

* [简介](README.md)

|

||||

* [基础知识](basic/README.md)

|

||||

* [模型评估](basic/evaluation.md)

|

||||

* [深度学习基础](basic/deep_basic.md)

|

||||

* [深度学习简述](basic/deep_learn.md)

|

||||

* [数学基础](basic/math_basis.md)

|

||||

* [图像相关](basic/pic/README.md)

|

||||

|

||||

* [决策树](decisionTree/README.md)

|

||||

|

||||

* [回归问题](regression/README.md)

|

||||

* [线性模型](regression/线性模型.md)

|

||||

|

||||

* [k-近邻算法](knn/README.md)

|

||||

|

||||

* [支持向量机](svm/README.md)

|

||||

|

||||

* [贝叶斯分类器](bayes/README.md)

|

||||

|

||||

* [神经网络](nn/README.md)

|

||||

* [RNN详解](nn/rnn.md)

|

||||

* [CNN详解](nn/cnn.md)

|

||||

* [多任务学习](nn/multi_task.md)

|

||||

* [ResNet详解](nn/ResNet.md)

|

||||

|

||||

* [目标检测](targetDetection/README.md)

|

||||

|

||||

* [自然语言理解与交互](nlp/README.md)

|

||||

|

||||

* [强化学习](rl/README.md)

|

||||

|

|

@ -0,0 +1,13 @@

|

|||

# 基础知识详解

|

||||

|

||||

## 机器学习数学基础相关的好文章合集

|

||||

1. [机器学习500问之数学基础](https://github.com/deel-learn/DeepLearning-500-questions/blob/master/ch1_%E6%95%B0%E5%AD%A6%E5%9F%BA%E7%A1%80/%E7%AC%AC%E4%B8%80%E7%AB%A0_%E6%95%B0%E5%AD%A6%E5%9F%BA%E7%A1%80.md)

|

||||

2. [深度学习基础](https://github.com/deel-learn/DeepLearning-500-questions/blob/master/ch3_%E6%B7%B1%E5%BA%A6%E5%AD%A6%E4%B9%A0%E5%9F%BA%E7%A1%80/%E7%AC%AC%E4%B8%89%E7%AB%A0_%E6%B7%B1%E5%BA%A6%E5%AD%A6%E4%B9%A0%E5%9F%BA%E7%A1%80.pdf)

|

||||

|

||||

|

||||

## 常见概念理解

|

||||

|

||||

1. [目标函数和损失函数的差别](https://blog.csdn.net/u011500062/article/details/55522609)

|

||||

2. [目标函数、损失函数、代价函数](https://www.davex.pw/2017/12/16/understand-loss-and-object-function/)

|

||||

|

||||

|

||||

|

|

@ -0,0 +1,34 @@

|

|||

# 深度学习基础

|

||||

|

||||

## 激活函数

|

||||

|

||||

### 常见的激活函数

|

||||

|

||||

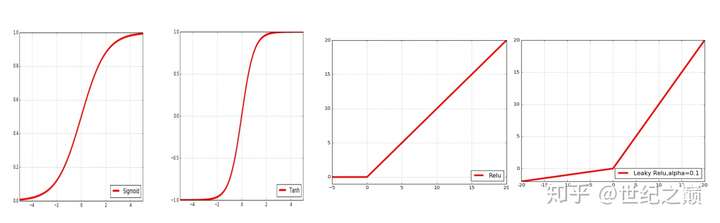

#### 1. sigmoid函数

|

||||

函数的定义$$ f(x) = \frac{1}{1 + e^{-x}} $$,其值域为 $$ (0,1) $$。 函数图像

|

||||

|

||||

|

||||

|

||||

#### 2. tanh激活函数

|

||||

函数的定义为:$$ f(x) = tanh(x) = \frac{e^x - e^{-x}}{e^x + e^{-x}} $$,值域为 $$ (-1,1) $$。函数图像

|

||||

|

||||

|

||||

|

||||

#### 3. Relu激活函数

|

||||

函数的定义为:$$ f(x) = max(0, x) $$ ,值域为 $$ [0,+∞) $$;函数图像

|

||||

|

||||

|

||||

|

||||

#### 4. Leak Relu激活函数

|

||||

函数定义为: $$ f(x) = \left{ \begin{aligned} ax, \quad x<0 \ x, \quad x>0 \end{aligned} \right. $$,值域为 $$ (-∞,+∞) $$。图像如下($$ a = 0.5 $$):

|

||||

|

||||

|

||||

|

||||

#### 5. SolftPlus 激活函数

|

||||

函数的定义为:$$ f(x) = ln( 1 + e^x) $$,值域为 $$ (0,+∞) $$。图像如下

|

||||

|

||||

|

||||

|

||||

#### 6. softmax激活函数

|

||||

函数定义为: $$ \sigma(z)j = \frac{e^{z_j}}{\sum{k=1}^K e^{z_k}} $$。

|

||||

Softmax 多用于多分类神经网络输出。

|

||||

|

|

@ -0,0 +1,45 @@

|

|||

## 深度模型的局限性

|

||||

随着深度学习的不断进步以及数据处理能力的不断提升,各大研究机构及科技巨头相继对深度学习领域投入了大量的资金和精力,并取得

|

||||

了惊人的成就。然而,我们不能忽略的一个重要问题是,深度学习实际上仍然存在着局限性:

|

||||

|

||||

### 深度学习需要大量的训练数据

|

||||

度学习的性能,能否提升取决于数据集的大小,因此深度学习通常需要大量的数据作为支撑,如果不能进行大量有效的训练,往往会导致

|

||||

过拟合(过拟合是指深度学习时选择的模型所包含的参数过多,以至于出现这一模型对已知数据预测得很好,但对未知数据预测得很差的

|

||||

现象)现象的产生。

|

||||

|

||||

|

||||

### 缺乏推理能力

|

||||

深度学习能够发现事件之间的关联性,建立事件之间的映射关系,但是深度学习不能解释因果关系。简单来说,深度学习学到的是输入与

|

||||

输出特征间的复杂关系,而非因果性的表征。深度学习可以把人类当作整体,并学习到身高与词汇量的相关性,但并不能了解到长大与发

|

||||

展间的关系。也就是说,孩子随着长大会学到更多单词,但这并不代表学习更多单词会让孩子长大。

|

||||

|

||||

### 深度网络对图像的改变过于敏感

|

||||

|

||||

在人类看来,对图片进行局部调整可能并会不影响对图的判断。然而,深度网络不仅对标准对抗攻击敏感,而且对环境的变化也会敏感。

|

||||

下图显示了在一张丛林猴子的照片中PS上一把吉他的效果。这导致深度网络将猴子误认为人类,同时将吉他误认为鸟,大概是因为它认为

|

||||

人类比猴子更可能携带吉他,而鸟类比吉他更可能出现在附近的丛林中。

|

||||

|

||||

|

||||

图:添加遮蔽体会导致深度网络失效。左:用摩托车进行遮挡后,猴子被识别为人类。中:用自行车进行遮挡后,猴子被识别为人类,同

|

||||

时丛林背景导致自行车把手被误认为是鸟。右:用吉他进行遮挡后,猴子被识别为人类,而丛林把吉他变成了鸟.

|

||||

|

||||

类似地,通过梯度上升,可以稍微修改图像,以便最大化给定类的类预测。通过拍摄一只熊猫,并添加一个“长臂猿”梯度,我们可以得到

|

||||

一个神经网络将这只熊猫分类为长臂猿。这证明了这些模型的脆弱性,以及它们运行的输入到输出映射与我们自己的人类感知之间的深刻

|

||||

差异。

|

||||

|

||||

|

||||

|

||||

|

||||

### 无法判断数据的正确性

|

||||

|

||||

深度学习可以在不理解数据的情况下模仿数据中的内容,它不会否定任何数据,不会发现数据中隐藏的偏见,这就可能会造成最终生成

|

||||

结果的不客观。

|

||||

|

||||

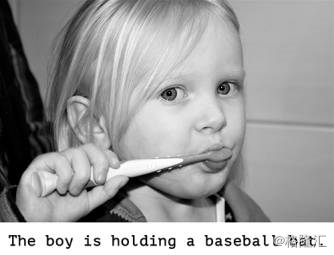

人工智能目前具有的一个非常真实的风险——人们误解了深度学习模型,并高估了它们的能力。人类思想的一个根本特征是我们的“思想理

|

||||

论”,我们倾向于对我们周围的事物设计意向、信仰和知识。在岩石上画一个笑脸,突然让我们“开心”。应用于深度学习,这意味着,例

|

||||

如,当我们能够成功地训练一个模型以生成描述图片的说明时,我们误认为该模型“理解”了图片的内容以及图片所生成的内容。但是,当

|

||||

训练数据中的图像存在轻微的偏离,使得模型开始生成完全荒谬的说明时,我们又非常惊讶。

|

||||

|

||||

|

||||

|

||||

案例:这个“男孩”正拿着一个“棒球棒”(正确说明应该是“这个女孩正拿着牙刷”)

|

||||

|

|

@ -0,0 +1,90 @@

|

|||

# 评估方法

|

||||

## 留出法

|

||||

留出法(hold-out)直接将数据集D划分为两个互斥的集合,其中一个集合作为训练集S,另一个作为测试集T,即有$$D=S∪T,S∩T=∅ $$

|

||||

建议:<br>

|

||||

训练集/测试集:2/3~4/5

|

||||

|

||||

## 交叉验证法

|

||||

交叉验证法(cross validation)先将数据集D划分为k个大小相似的互斥子集。即有:$$D=D1∪D2∪...∪Dk,Di∩Dj=∅$$

|

||||

每个子集Di都尽可能保持数据分布的一致性,即从D中通过分层采样得到。然后,每次用k-1个子集的并集作为训练集,余下的那个子集

|

||||

作为测试集,这样就可以获得k组训练/测试集。从而可以进行k次训练与测试,最终返回的是这k个测试结果的均值。<br>

|

||||

<br>

|

||||

缺陷:数据集较大时,计算开销。同时留一法的估计结果也未必比其他评估方法准确。

|

||||

|

||||

## 自助法

|

||||

简单的说,它从数据集D中每次随机取出一个样本,将其拷贝一份放入新的采样数据集D′,样本放回原数据集中,重复这个过程m次,就得

|

||||

到了同样包含m个样本的数据集D′,显然D中会有一部分数据会在D′中重复出现。样本在m次采样中始终不被采样到的概率是

|

||||

,取极限得到:<br>

|

||||

<br>

|

||||

即通过自助法,初始数据集中约有36.8%样本未出现在采样数据集D′中。可将D′作为训练集,D\D′作为测试集,(\表示集合的减法)。保

|

||||

证了实际评估的模型与期望评估的模型都是用m个训练样本,而有数据总量约1/3的、没在训练集中出过的样本用于测试,这样的测试结

|

||||

果,也叫做”包外估计”(out-of-bagestimate).

|

||||

|

||||

### 适用场景

|

||||

自助法在数据集较小、难以有效划分训练/测试集很有用;此外自助法可以从初始数据集中产生多个不同的训练集,这对集成学习等方法

|

||||

有很大好处。

|

||||

|

||||

### 缺点

|

||||

自助法产生的数据集改变了初始数据集的分布,引入估计偏差。故在数据量足够时,留出法与交叉验证更为常用。

|

||||

|

||||

# 性能度量

|

||||

在预测任务中,给定样本集

|

||||

|

||||

其中,yi是示例xi的真实标记。回归任务中最常用的性能度量是均方误差(mean squeared error),f(x)是机器学习预测结果<br>

|

||||

<br>

|

||||

更一般的形式(数据分布D,概率密度函数p(x))<br>

|

||||

|

||||

|

||||

## 错误率和精度

|

||||

错误率的定义:<br>

|

||||

<br>

|

||||

更一般的定义:<br>

|

||||

<br>

|

||||

精度的定义:<br>

|

||||

<br>

|

||||

更一般的定义:<br>

|

||||

|

||||

|

||||

## 查准率、查全率与F1

|

||||

下表是二分类结果混淆矩阵,将判断结果分为四个类别,真正例(TP)、假正例(FP)、假反例(FN)、真反例(TN)。<br>

|

||||

<br>

|

||||

查准率:【真正例样本数】与【预测结果是正例的样本数】的比值。<br>

|

||||

查全率:【真正例样本数】与【真实情况是正例的样本数】的比值。 <br>

|

||||

<br>

|

||||

- 当曲线没有交叉的时候:外侧曲线的学习器性能优于内侧;

|

||||

- 当曲线有交叉的时候:

|

||||

- 第一种方法是比较曲线下面积,但值不太容易估算;

|

||||

- 第二种方法是比较两条曲线的平衡点,平衡点是“查准率=查全率”时的取值,在图中表示为曲线和对角线的交点。平衡点在外侧的

|

||||

曲线的学习器性能优于内侧。

|

||||

- 第三种方法是F1度量和Fβ度量。F1是基于查准率与查全率的调和平均定义的,Fβ则是加权调和平均。<br>

|

||||

<br>

|

||||

<br>

|

||||

|

||||

|

||||

## ROC与AUC

|

||||

ROC曲线便是从这个角度出发来研究学习器泛化性能的有力工具。<br>

|

||||

与P-R曲线使用查准率、查全率为横纵轴不同,ROC的纵轴是”真正样例(True Positive Rate,简称TPR)”,横轴是“假正例率(False

|

||||

Positive Rate,简称FPR),两者分别定义为<br>

|

||||

<br>

|

||||

显示ROC的曲线图称为“ROC图”<br>

|

||||

<br>

|

||||

进行学习器比较时,与P-R如相似,若一个学习器的ROC曲线被另一个学习器的曲线“包住”,则可断言后者的性能优于前者;若两个学习

|

||||

器的ROC曲线发生交叉,则难以一般性的断言两者孰优孰劣。此时如果一定要进行比较,则较为合理的判断是比较ROC曲线下的面积,

|

||||

即AUC(Area Under ROC Curve)。

|

||||

|

||||

注意:AUC计算公式没看懂

|

||||

|

||||

## 代价敏感错误率与代价曲线

|

||||

在现实任务中会遇到这样的情况:不同类型错误所造成的后果不同。以二分类任务为例,我们可根据任务领域知识设定一个“代价矩阵”,

|

||||

如下图所示,<br>

|

||||

<br>

|

||||

在非均等代价下,ROC曲线不能直接反映出学习器的期望总体代价,而“代价曲线(cost curve)”则可达到目的。代价曲线图的横轴是取

|

||||

值为[0,1]的正例概率代价,<br>

|

||||

<br>

|

||||

纵轴是取值为[0,1]的归一化代价<br>

|

||||

<br>

|

||||

画图表示如下图所示 <br>

|

||||

<br>

|

||||

|

||||

# 比较检验

|

||||

|

||||

|

|

@ -0,0 +1,43 @@

|

|||

# 数学基础

|

||||

|

||||

## 标量、向量、矩阵、张量之间的联系

|

||||

### 标量(scalar)

|

||||

一个标量表示一个单独的数,它不同于线性代数中研究的其他大部分对象(通常是多个数的数组)。我们用斜体表示标量。标量通常被

|

||||

赋予小写的变量名称。

|

||||

### 向量(vector)

|

||||

一个向量表示组有序排列的数。通过次序中的索引,我们可以确定每个单独的数。通常我们赋予向量粗体的小写变量名称,比如xx。向量

|

||||

中的元素可以通过带脚标的斜体表示。向量x的第一个元素是x1,第二个元素是x2,以此类推。我们也会注明存储在向量中的元素的类型

|

||||

(实数、虚数等)。

|

||||

### 矩阵(matrix)

|

||||

矩阵是具有相同特征和纬度的对象的集合,表现为一张二维数据表。其意义是一个对象表示为矩阵中的一行,一个特征表示为矩阵中的一

|

||||

列,每个特征都有数值型的取值。通常会赋予矩阵粗体的大写变量名称,比如A。

|

||||

### 张量(tensor)

|

||||

在某些情况下,我们会讨论坐标超过两维的数组。一般地,一个数组中的元素分布在若干维坐标的规则网格中,我们将其称之为张量。

|

||||

|

||||

### 奇异值分解

|

||||

[https://zhuanlan.zhihu.com/p/26306568 ](https://zhuanlan.zhihu.com/p/26306568)

|

||||

|

||||

## 常见概率分布

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

## 数值计算

|

||||

|

||||

[Jacobian矩阵和Hessian矩阵](https://www.cnblogs.com/wangyarui/p/6407604.html)

|

||||

|

||||

## 估计、偏差、方差

|

||||

[偏差和方差](http://liuchengxu.org/blog-cn/posts/bias-variance/)

|

||||

|

||||

## 极大似然估计

|

||||

[相对熵(KL散度)](https://blog.csdn.net/ACdreamers/article/details/44657745)

|

||||

|

||||

极大似然相关理解

|

||||

1. [https://www.jiqizhixin.com/articles/2018-01-09-6 ](https://www.jiqizhixin.com/articles/2018-01-09-6)

|

||||

|

||||

|

||||

|

||||

|

|

@ -0,0 +1,12 @@

|

|||

# 图片相关基础知识

|

||||

|

||||

## 上采样和下采样

|

||||

|

||||

### 上采样

|

||||

|

||||

|

||||

|

||||

### 下采样

|

||||

|

||||

|

||||

|

||||

|

|

@ -0,0 +1,81 @@

|

|||

# 朴素贝叶斯

|

||||

|

||||

叶斯分类器是一种概率框架下的统计学习分类器,对分类任务而言,假设在相关概率都已知的情况下,贝叶斯分类器考虑如何基于这些概

|

||||

率为样本判定最优的类标。在开始介绍贝叶斯决策论之前,我们首先来回顾下概率论委员会常委--贝叶斯公式。

|

||||

|

||||

<br>

|

||||

|

||||

### 条件概率

|

||||

朴素贝叶斯最核心的部分是贝叶斯法则,而贝叶斯法则的基石是条件概率。贝叶斯法则如下:

|

||||

|

||||

<br>

|

||||

|

||||

对于给定的样本x,P(x)与类标无关,P(c)称为类先验概率,p(x | c )称为类条件概率。这时估计后验概率P(c | x)就变成为

|

||||

估计类先验概率和类条件概率的问题。对于先验概率和后验概率,在看这章之前也是模糊了我好久,这里普及一下它们的基本概念。

|

||||

|

||||

> 先验概率: 根据以往经验和分析得到的概率。<br>

|

||||

> 后验概率:后验概率是基于新的信息,修正原来的先验概率后所获得的更接近实际情况的概率估计。

|

||||

|

||||

实际上先验概率就是在没有任何结果出来的情况下估计的概率,而后验概率则是在有一定依据后的重新估计,直观意义上后验概率就是条

|

||||

件概率。

|

||||

|

||||

<br>

|

||||

|

||||

回归正题,对于类先验概率P(c),p(c)就是样本空间中各类样本所占的比例,根据大数定理(当样本足够多时,频率趋于稳定等于其

|

||||

概率),这样当训练样本充足时,p(c)可以使用各类出现的频率来代替。因此只剩下类条件概率p(x | c ),它表达的意思是在类别c中

|

||||

出现x的概率,它涉及到属性的联合概率问题,若只有一个离散属性还好,当属性多时采用频率估计起来就十分困难,因此这里一般采用

|

||||

极大似然法进行估计。

|

||||

|

||||

### 极大似然法

|

||||

极大似然估计(Maximum Likelihood Estimation,简称MLE),是一种根据数据采样来估计概率分布的经典方法。常用的策略是先假定总

|

||||

体具有某种确定的概率分布,再基于训练样本对概率分布的参数进行估计。运用到类条件概率p(x | c )中,假设p(x | c )服从一个

|

||||

参数为θ的分布,问题就变为根据已知的训练样本来估计θ。极大似然法的核心思想就是:估计出的参数使得已知样本出现的概率最大,即

|

||||

使得训练数据的似然最大。

|

||||

|

||||

<br>

|

||||

|

||||

所以,贝叶斯分类器的训练过程就是参数估计。总结最大似然法估计参数的过程,一般分为以下四个步骤:

|

||||

|

||||

> 1. 写出似然函数;<br>

|

||||

> 2. 对似然函数取对数,并整理;<br>

|

||||

> 3. 求导数,令偏导数为0,得到似然方程组;<br>

|

||||

> 4. 解似然方程组,得到所有参数即为所求。

|

||||

|

||||

例如:假设样本属性都是连续值,p(x | c )服从一个多维高斯分布,则通过MLE计算出的参数刚好分别为:

|

||||

|

||||

<br>

|

||||

|

||||

上述结果看起来十分合乎实际,但是采用最大似然法估计参数的效果很大程度上依赖于作出的假设是否合理,是否符合潜在的真实数据分

|

||||

布。这就需要大量的经验知识,搞统计越来越值钱也是这个道理,大牛们掐指一算比我们搬砖几天更有效果。

|

||||

|

||||

### 朴素贝叶斯分类器

|

||||

不难看出:原始的贝叶斯分类器最大的问题在于联合概率密度函数的估计,首先需要根据经验来假设联合概率分布,其次当属性很多时,

|

||||

训练样本往往覆盖不够,参数的估计会出现很大的偏差。为了避免这个问题,朴素贝叶斯分类器(naive Bayes classifier)采用了“属

|

||||

性条件独立性假设”,即样本数据的所有属性之间相互独立。这样类条件概率p(x | c )可以改写为:

|

||||

|

||||

<br>

|

||||

|

||||

这样,为每个样本估计类条件概率变成为每个样本的每个属性估计类条件概率。

|

||||

|

||||

<br>

|

||||

|

||||

相比原始贝叶斯分类器,朴素贝叶斯分类器基于单个的属性计算类条件概率更加容易操作,需要注意的是:若某个属性值在训练集中和某

|

||||

个类别没有一起出现过,这样会抹掉其它的属性信息,因为该样本的类条件概率被计算为0。因此在估计概率值时,常常用进行平滑(

|

||||

smoothing)处理,拉普拉斯修正(Laplacian correction)就是其中的一种经典方法,具体计算方法如下:

|

||||

|

||||

<br>

|

||||

|

||||

当训练集越大时,拉普拉斯修正引入的影响越来越小。对于贝叶斯分类器,模型的训练就是参数估计,因此可以事先将所有的概率储存好

|

||||

,当有新样本需要判定时,直接查表计算即可。

|

||||

|

||||

### 词集模型

|

||||

对于给定文档,只统计某个侮辱性词汇(准确说是词条)是否在本文档出现

|

||||

|

||||

### 词袋模型

|

||||

对于给定文档,统计某个侮辱性词汇在本文当中出现的频率,除此之外,往往还需要剔除重要性极低的高频词和停用词。因此,

|

||||

词袋模型更精炼,也更有效。

|

||||

|

||||

## 数据预处理

|

||||

|

||||

### 向量化

|

||||

向量化、矩阵化操作是机器学习的追求。从数学表达式上看,向量化、矩阵化表示更加简洁;在实际操作中,矩阵化(向量是特殊的矩阵)更高效。

|

||||

|

|

@ -0,0 +1,83 @@

|

|||

#!/usr/bin/env python3

|

||||

# coding:utf-8

|

||||

import numpy as np

|

||||

|

||||

|

||||

def load_data_set():

|

||||

posting_list = [['my', 'dog', 'has', 'flea', 'problems', 'help', 'please'],

|

||||

['maybe', 'not', 'take', 'him', 'dog', 'park', 'stupid'],

|

||||

['my', 'dalmation', 'is', 'so', 'cute', '_i', 'love', 'him'],

|

||||

['stop', 'posting', 'stupid', 'worthless', 'garbage'],

|

||||

['mr', 'licks', 'ate', 'my', 'steak', 'how', 'to', 'stop', 'him'],

|

||||

['quit', 'buying', 'worthless', 'dog', 'food', 'stupid']]

|

||||

|

||||

class_vec = [0, 1, 0, 1, 0, 1]

|

||||

return posting_list, class_vec

|

||||

|

||||

|

||||

def create_vocab_list(data_set):

|

||||

vocab_set = set([])

|

||||

for document in data_set:

|

||||

vocab_set = vocab_set | set(document)

|

||||

|

||||

return list(vocab_set)

|

||||

|

||||

|

||||

def set_of_words2_vec(vocab_list, input_set):

|

||||

return_vec = [0] * len(vocab_list)

|

||||

for word in input_set:

|

||||

if word in vocab_list:

|

||||

return_vec[vocab_list.index(word)] = 1

|

||||

else:

|

||||

print("the word:%s is not in my vocabulary!", word)

|

||||

|

||||

return return_vec

|

||||

|

||||

|

||||

# 贝叶斯分类器训练函数

|

||||

def train_nb0(train_matrix, train_category):

|

||||

num_train_docs = len(train_matrix)

|

||||

num_words = len(train_matrix[0])

|

||||

p_abusive = sum(train_category)/float(num_train_docs)

|

||||

p0_num = np.zeros(num_words)

|

||||

p1_num = np.zeros(num_words)

|

||||

p0_denom = 0.0

|

||||

p1_denom = 0.0

|

||||

for i in range(num_train_docs):

|

||||

if train_category[i] == 1:

|

||||

p1_num += train_matrix[i]

|

||||

p1_denom += sum(train_matrix[i])

|

||||

else:

|

||||

p0_num += train_matrix[i]

|

||||

p0_denom += sum(train_matrix[i])

|

||||

|

||||

p1_vect = p1_num/p1_denom

|

||||

p0_vect = p0_num/p0_denom

|

||||

return p0_vect, p1_vect, p_abusive

|

||||

|

||||

|

||||

def classify_nb(vec2_classify, p0_vec, p1_vec, p_class1):

|

||||

p1 = sum(vec2_classify * p1_vec) + np.log(p_class1)

|

||||

p0 = sum(vec2_classify * p0_vec) + np.log(1.0 - p_class1)

|

||||

if p1 > p0:

|

||||

return 1

|

||||

else:

|

||||

return 0

|

||||

|

||||

|

||||

def testing_nb():

|

||||

list0_posts, list_classes = load_data_set()

|

||||

my_vocab_list = create_vocab_list(list0_posts)

|

||||

train_mat = []

|

||||

for postin_doc in list0_posts:

|

||||

train_mat.append(set_of_words2_vec(my_vocab_list, postin_doc))

|

||||

p0_v, p1_v, p_ab = train_nb0(np.array(train_mat), np.array(list_classes))

|

||||

test_entry = ['love', 'my', 'dalmation']

|

||||

this_doc = np.array(set_of_words2_vec(my_vocab_list, test_entry))

|

||||

print(test_entry, 'classsified as:', classify_nb(this_doc, p0_v, p1_v, p_ab))

|

||||

test_entry = ['stupid', 'garbage']

|

||||

this_doc = np.array(set_of_words2_vec(my_vocab_list, test_entry))

|

||||

print(test_entry, 'classsified as:', classify_nb(this_doc, p0_v, p1_v, p_ab))

|

||||

|

||||

|

||||

testing_nb()

|

||||

|

|

@ -0,0 +1,75 @@

|

|||

{

|

||||

"root":"./",

|

||||

"author":"小令童鞋",

|

||||

"description":"没有到不了的明天,只有回不了的昨天",

|

||||

"plugins":["github",

|

||||

"-sharing",

|

||||

"-search",

|

||||

"sharing-plus",

|

||||

"-highlight",

|

||||

"expandable-chapters-small",

|

||||

"mathjax",

|

||||

"splitter",

|

||||

"disqus",

|

||||

"3-ba",

|

||||

"theme-comscore",

|

||||

"search-plus",

|

||||

"prism",

|

||||

"prism-themes",

|

||||

"github-buttons",

|

||||

"ad",

|

||||

"tbfed-pagefooter",

|

||||

"ga",

|

||||

"alerts",

|

||||

"anchors",

|

||||

"include-codeblock",

|

||||

"ace"

|

||||

],

|

||||

"links":{

|

||||

"sidebar":{

|

||||

"主页":"http://www.zeekling.cn"

|

||||

}

|

||||

},

|

||||

"pluginsConfig":{

|

||||

"sharing":{

|

||||

"douban":false,

|

||||

"facebook":false,

|

||||

"qq":false,

|

||||

"qzone":false,

|

||||

"google":false,

|

||||

"all": [

|

||||

"weibo","qq","qzone","google","douban"

|

||||

]

|

||||

},

|

||||

"disqus":{

|

||||

"shortName":"zeekling"

|

||||

},

|

||||

"ad":{

|

||||

|

||||

},

|

||||

"include-codeblock":{

|

||||

"template":"ace",

|

||||

"unindent":true,

|

||||

"theme":"monokai"

|

||||

},

|

||||

"tbfed-pagefooter":{

|

||||

"Copyright":"© zeekling.cn",

|

||||

"modify_label":"文件修改时间",

|

||||

"modify_format":"YYYY-MM-DD HH:mm:ss"

|

||||

},

|

||||

"3-ba":{

|

||||

"token":"zeekling"

|

||||

},

|

||||

"ga":{

|

||||

"token":"zeekling",

|

||||

"configuration":{

|

||||

"cookieName":"zeekling",

|

||||

"cookieDomain":"book.zeekling.cn"

|

||||

}

|

||||

},

|

||||

"github":{"url":"http://www.zeekling.cn/gogs/zeek"},

|

||||

"theme-default": {

|

||||

"showLevel": true

|

||||

}

|

||||

}

|

||||

}

|

||||

|

|

@ -0,0 +1,3 @@

|

|||

#!/usr/bin/env python

|

||||

# -*- coding: UTF-8 -*-

|

||||

|

||||

|

|

@ -0,0 +1,97 @@

|

|||

# 决策树

|

||||

|

||||

|

||||

# 决策树的构造

|

||||

决策树的构造是一个递归的过程,有三种情形会导致递归返回:(1) 当前结点包含的样本全属于同一类别,这时直接将该节点标记为叶节

|

||||

点,并设为相应的类别;(2) 当前属性集为空,或是所有样本在所有属性上取值相同,无法划分,这时将该节点标记为叶节点,并将其类

|

||||

别设为该节点所含样本最多的类别;(3) 当前结点包含的样本集合为空,不能划分,这时也将该节点标记为叶节点,并将其类别设为父节

|

||||

点中所含样本最多的类别。算法的基本流程如下图所示:

|

||||

|

||||

<br>

|

||||

|

||||

可以看出:决策树学习的关键在于如何选择划分属性,不同的划分属性得出不同的分支结构,从而影响整颗决策树的性能。属性划分的目

|

||||

标是让各个划分出来的子节点尽可能地“纯”,即属于同一类别。

|

||||

|

||||

## 数学归纳算法(ID3)

|

||||

### 信息增益

|

||||

|

||||

相关概念

|

||||

1. 熵:表示随机变量的不确定性。

|

||||

2. 条件熵:在一个条件下,随机变量的不确定性。

|

||||

3. 信息增益:熵 - 条件熵,在一个条件下,信息不确定性减少的程度!

|

||||

|

||||

### 信息熵

|

||||

ID3算法使用信息增益为准则来选择划分属性,“信息熵”(information entropy)是度量样本结合纯度的常用指标,假定当前样本集合D中

|

||||

第k类样本所占比例为pk,则样本集合D的信息熵定义为:

|

||||

|

||||

|

||||

信息熵特点

|

||||

> 1. 不同类别的概率分布越均匀,信息熵越大;

|

||||

> 2. 类别个数越多,信息熵越大;

|

||||

> 3. 信息熵越大,越不容易被预测;(变化个数多,变化之间区分小,则越不容易被预测)(对于确定性问题,信息熵为0;p=1; E=p*logp=0)<br>

|

||||

> 相关理解:[通俗理解信息熵](https://zhuanlan.zhihu.com/p/26486223)、[条件熵](https://zhuanlan.zhihu.com/p/26551798)

|

||||

|

||||

假定通过属性划分样本集D,产生了V个分支节点,v表示其中第v个分支节点,易知:分支节点包含的样本数越多,表示该分支节点的影响

|

||||

力越大。故可以计算出划分后相比原始数据集D获得的“信息增益”(information gain)。

|

||||

|

||||

<br>

|

||||

信息增益越大,表示使用该属性划分样本集D的效果越好,因此ID3算法在递归过程中,每次选择最大信息增益的属性作为当前的划分属性。

|

||||

|

||||

### C4.5算法

|

||||

ID3算法存在一个问题,就是偏向于取值数目较多的属性,例如:如果存在一个唯一标识,这样样本集D将会被划分为|D|个分支,每个分

|

||||

支只有一个样本,这样划分后的信息熵为零,十分纯净,但是对分类毫无用处。因此C4.5算法使用了“增益率”(gain ratio)来选择划分

|

||||

属性,来避免这个问题带来的困扰。首先使用ID3算法计算出信息增益高于平均水平的候选属性,接着C4.5计算这些候选属性的增益率,

|

||||

增益率定义为:

|

||||

<br><br>

|

||||

|

||||

### cart算法

|

||||

CART决策树使用“基尼指数”(Gini index)来选择划分属性,基尼指数反映的是从样本集D中随机抽取两个样本,其类别标记不一致的概

|

||||

率,因此Gini(D)越小越好,基尼指数定义如下:

|

||||

<br><br>

|

||||

进而,使用属性α划分后的基尼指数为:

|

||||

<br><br>

|

||||

|

||||

## 剪枝处理

|

||||

从决策树的构造流程中我们可以直观地看出:不管怎么样的训练集,决策树总是能很好地将各个类别分离开来,这时就会遇到之前提到过

|

||||

的问题:过拟合(overfitting),即太依赖于训练样本。剪枝(pruning)则是决策树算法对付过拟合的主要手段,剪枝的策略有两种如

|

||||

下:

|

||||

> * 预剪枝(prepruning):在构造的过程中先评估,再考虑是否分支。

|

||||

> * 后剪枝(post-pruning):在构造好一颗完整的决策树后,自底向上,评估分支的必要性。

|

||||

|

||||

评估指的是性能度量,即决策树的泛化性能。之前提到:可以使用测试集作为学习器泛化性能的近似,因此可以将数据集划分为训练集和

|

||||

测试集。预剪枝表示在构造数的过程中,对一个节点考虑是否分支时,首先计算决策树不分支时在测试集上的性能,再计算分支之后的性

|

||||

能,若分支对性能没有提升,则选择不分支(即剪枝)。后剪枝则表示在构造好一颗完整的决策树后,从最下面的节点开始,考虑该节点

|

||||

分支对模型的性能是否有提升,若无则剪枝,即将该节点标记为叶子节点,类别标记为其包含样本最多的类别。

|

||||

<br><br>

|

||||

<br><br>

|

||||

<br><br>

|

||||

上图分别表示不剪枝处理的决策树、预剪枝决策树和后剪枝决策树。预剪枝处理使得决策树的很多分支被剪掉,因此大大降低了训练时间

|

||||

开销,同时降低了过拟合的风险,但另一方面由于剪枝同时剪掉了当前节点后续子节点的分支,因此预剪枝“贪心”的本质阻止了分支的展

|

||||

开,在一定程度上带来了欠拟合的风险。而后剪枝则通常保留了更多的分支,因此采用后剪枝策略的决策树性能往往优于预剪枝,但其自

|

||||

底向上遍历了所有节点,并计算性能,训练时间开销相比预剪枝大大提升。

|

||||

|

||||

|

||||

## 连续值与缺失值处理

|

||||

对于连续值的属性,若每个取值作为一个分支则显得不可行,因此需要进行离散化处理,常用的方法为二分法,基本思想为:给定样本集

|

||||

D与连续属性α,二分法试图找到一个划分点t将样本集D在属性α上分为≤t与>t。

|

||||

> * 首先将α的所有取值按升序排列,所有相邻属性的均值作为候选划分点(n-1个,n为α所有的取值数目)。

|

||||

> * 计算每一个划分点划分集合D(即划分为两个分支)后的信息增益。

|

||||

> * 选择最大信息增益的划分点作为最优划分点。

|

||||

|

||||

<br><br>

|

||||

现实中常会遇到不完整的样本,即某些属性值缺失。有时若简单采取剔除,则会造成大量的信息浪费,因此在属性值缺失的情况下需要解

|

||||

决两个问题:(1)如何选择划分属性。(2)给定划分属性,若某样本在该属性上缺失值,如何划分到具体的分支上。假定为样本集中的

|

||||

每一个样本都赋予一个权重,根节点中的权重初始化为1,则定义:

|

||||

<br><br>

|

||||

对于(1):通过在样本集D中选取在属性α上没有缺失值的样本子集,计算在该样本子集上的信息增益,最终的信息增益等于该样本子集

|

||||

划分后信息增益乘以样本子集占样本集的比重。即:

|

||||

<br><br>

|

||||

对于(2):若该样本子集在属性α上的值缺失,则将该样本以不同的权重(即每个分支所含样本比例)划入到所有分支节点中。该样本在

|

||||

分支节点中的权重变为:

|

||||

<br><br>

|

||||

|

||||

|

||||

## 优缺点

|

||||

- 处理连续变量不好

|

||||

- 类型比较多的时候错误增加的比较快

|

||||

- 可规模性一般

|

||||

Binary file not shown.

|

After Width: | Height: | Size: 5.7 KiB |

Binary file not shown.

|

After Width: | Height: | Size: 1.9 KiB |

|

|

@ -0,0 +1,78 @@

|

|||

#!/usr/bin/env python

|

||||

# coding: utf-8

|

||||

|

||||

from math import log

|

||||

|

||||

|

||||

# 计算香农熵

|

||||

def calcShannonEnt(dataSet):

|

||||

numEntries = len(dataSet)

|

||||

labelCounts = {}

|

||||

for featVec in dataSet:

|

||||

currentLabel = featVec[-1]

|

||||

if currentLabel not in labelCounts:

|

||||

labelCounts[currentLabel] = 0

|

||||

labelCounts[currentLabel] += 1

|

||||

shannonEnt = 0.0

|

||||

for key in labelCounts:

|

||||

prob = float(labelCounts[key]) / numEntries

|

||||

shannonEnt -= prob * log(prob, 2)

|

||||

return shannonEnt

|

||||

|

||||

|

||||

# 初始值

|

||||

def createDataSet():

|

||||

dataSet = [[1, 1, 'yes'],

|

||||

[1, 0, 'yes'],

|

||||

[1, 0, 'no'],

|

||||

[0, 1, 'no'],

|

||||

[0, 1, 'no']]

|

||||

label = ['no surfaceing', 'flippers']

|

||||

return dataSet, label

|

||||

|

||||

|

||||

# 按照给定特征划分数据集

|

||||

def splitDataSet(dataSet, axis, value):

|

||||

retDataSet = []

|

||||

for featVec in dataSet:

|

||||

if featVec[axis] == value:

|

||||

reducedFeatVec = featVec[:axis]

|

||||

reducedFeatVec.extend(featVec[axis + 1:])

|

||||

retDataSet.append(reducedFeatVec)

|

||||

return retDataSet

|

||||

|

||||

|

||||

# 选择最好数据集的划分方式

|

||||

def choooseBestFeatureToSplit(dataSet):

|

||||

numFeatures = len(dataSet)

|

||||

baseEntropy = calcShannonEnt(dataSet)

|

||||

bestInfoGain = 0.0

|

||||

bestFeature = -1

|

||||

for i in range(numFeatures):

|

||||

featList = [example[i] for example in dataSet]

|

||||

uniqyeVals = set(featList)

|

||||

newEntropy = 0.0

|

||||

for value in uniqyeVals:

|

||||

subDataSet = splitDataSet(dataSet, i, value)

|

||||

prob = len(subDataSet)/float(len(dataSet))

|

||||

newEntropy += prob * calcShannonEnt(subDataSet)

|

||||

infoGain = baseEntropy - newEntropy

|

||||

if (infoGain > bestInfoGain):

|

||||

bestInfoGain = infoGain

|

||||

bestFeature = i

|

||||

return bestFeature

|

||||

|

||||

"""

|

||||

myData, labels = createDataSet()

|

||||

print(myData)

|

||||

calcShannonEnt(myData)

|

||||

myData[0][-1] = 'maybe'

|

||||

print(myData)

|

||||

shannonEnt = calcShannonEnt(myData)

|

||||

print(shannonEnt)

|

||||

myData[0][-1] = 'yes'

|

||||

data = splitDataSet(myData, 0, 1)

|

||||

print(data)

|

||||

data = splitDataSet(myData, 0, 0)

|

||||

print(data)

|

||||

"""

|

||||

|

|

@ -0,0 +1,9 @@

|

|||

<html>

|

||||

<head>机器学习</head>

|

||||

<body>

|

||||

|

||||

</body>

|

||||

<script>

|

||||

window.location.href = "./_book/";

|

||||

</script>

|

||||

</html>

|

||||

|

|

@ -0,0 +1,13 @@

|

|||

#!/usr/bin/env python3

|

||||

# -*- coding: UTF-8 -*-

|

||||

import math

|

||||

|

||||

|

||||

def computeEuclideanDistance(x1, y1, x2, y2):

|

||||

d = math.sqrt(math.pow((x1 - x2), 2) + math.pow((y1 - y2), 2))

|

||||

return d

|

||||

|

||||

|

||||

d_ag = computeEuclideanDistance(3, 104, 18, 90)

|

||||

|

||||

print(d_ag)

|

||||

|

|

@ -0,0 +1,18 @@

|

|||

# k-近邻算法

|

||||

|

||||

K最近邻(k-Nearest Neighbor,KNN)分类算法,是一个理论上比较不成熟的方法,也是最简单的机器学习算法之一。

|

||||

该方法的思路是:如果一个样本在特征空间中的k个最相似(即特征空间中最邻近)的样本中的大多数属于某一个类别,则

|

||||

该样本也属于这个类别。

|

||||

|

||||

[详解](https://blog.csdn.net/taoyanqi8932/article/details/53727841)

|

||||

|

||||

|

||||

## 综述

|

||||

- 分类算法

|

||||

- 基于实例的学习,懒惰学习

|

||||

|

||||

## 算法详述

|

||||

|

||||

### 算法步骤

|

||||

为了判断实例的类别,以所有已知实例作为参照

|

||||

|

||||

|

|

@ -0,0 +1,17 @@

|

|||

#!/usr/bin/env python

|

||||

# -*- coding: UTF-8 -*-

|

||||

|

||||

from sklearn import neighbors

|

||||

from sklearn import datasets

|

||||

|

||||

knn = neighbors.KNeighborsClassifier()

|

||||

|

||||

iris = datasets.load_iris()

|

||||

|

||||

print iris

|

||||

|

||||

knn.fit(iris.data, iris.target)

|

||||

|

||||

predictedLabel = knn.predict([[0.1, 0.2, 0.3, 0.4]])

|

||||

|

||||

print predictedLabel

|

||||

|

|

@ -0,0 +1,30 @@

|

|||

#!/usr/bin/env python3

|

||||

# -*- coding:utf-8 -*-

|

||||

import numpy as np

|

||||

import operator

|

||||

|

||||

|

||||

def createDataSet():

|

||||

group = np.array([[1.0, 1.1], [1.0, 1.0], [0, 0], [0, 0.1]])

|

||||

labels = ['A', 'A', 'B', 'B']

|

||||

return group, labels

|

||||

|

||||

|

||||

# K-近邻算法

|

||||

def classify0(inX, dataSet, labels, k):

|

||||

dataSetSize = np.shape(dataSet)[0]

|

||||

diffMat = np.tile(inX, (dataSetSize, 1)) - dataSet

|

||||

sqDiffMat = diffMat ** 2

|

||||

sqDistances = np.sum(sqDiffMat, axis=1)

|

||||

distances = sqDistances ** 0.5

|

||||

sortedDistIndicies = np.argsort(distances)

|

||||

classCount = {}

|

||||

for i in range(k):

|

||||

voteLabel = labels[sortedDistIndicies[i]]

|

||||

classCount[voteLabel] = classCount.get(voteLabel, 0) + 1

|

||||

|

||||

sortedClassCount = np.sort(classCount.iteritems(),

|

||||

key=operator.itemgetter(0),

|

||||

reversed=True)

|

||||

|

||||

return sortedClassCount

|

||||

|

|

@ -0,0 +1,231 @@

|

|||

#!/usr/bin/env python3

|

||||

# -*- coding:UTF-8 -*-

|

||||

from matplotlib.font_manager import FontProperties

|

||||

import matplotlib.pyplot as plt

|

||||

import numpy as np

|

||||

import random

|

||||

|

||||

|

||||

"""

|

||||

函数说明:加载数据

|

||||

|

||||

Parameters:

|

||||

无

|

||||

Returns:

|

||||

dataMat - 数据列表

|

||||

labelMat - 标签列表

|

||||

Author:

|

||||

Jack Cui

|

||||

Blog:

|

||||

http://blog.csdn.net/c406495762

|

||||

Zhihu:

|

||||

https://www.zhihu.com/people/Jack--Cui/

|

||||

Modify:

|

||||

2017-08-28

|

||||

"""

|

||||

def loadDataSet():

|

||||

dataMat = [] #创建数据列表

|

||||

labelMat = [] #创建标签列表

|

||||

fr = open('testSet.txt') #打开文件

|

||||

for line in fr.readlines(): #逐行读取

|

||||

lineArr = line.strip().split() #去回车,放入列表

|

||||

dataMat.append([1.0, float(lineArr[0]), float(lineArr[1])]) #添加数据

|

||||

labelMat.append(int(lineArr[2])) #添加标签

|

||||

fr.close() #关闭文件

|

||||

return dataMat, labelMat #返回

|

||||

|

||||

"""

|

||||

函数说明:sigmoid函数

|

||||

|

||||

Parameters:

|

||||

inX - 数据

|

||||

Returns:

|

||||

sigmoid函数

|

||||

Author:

|

||||

Jack Cui

|

||||

Blog:

|

||||

http://blog.csdn.net/c406495762

|

||||

Zhihu:

|

||||

https://www.zhihu.com/people/Jack--Cui/

|

||||

Modify:

|

||||

2017-08-28

|

||||

"""

|

||||

def sigmoid(inX):

|

||||

return 1.0 / (1 + np.exp(-inX))

|

||||

|

||||

"""

|

||||

函数说明:梯度上升算法

|

||||

|

||||

Parameters:

|

||||

dataMatIn - 数据集

|

||||

classLabels - 数据标签

|

||||

Returns:

|

||||

weights.getA() - 求得的权重数组(最优参数)

|

||||

weights_array - 每次更新的回归系数

|

||||

Author:

|

||||

Jack Cui

|

||||

Blog:

|

||||

http://blog.csdn.net/c406495762

|

||||

Zhihu:

|

||||

https://www.zhihu.com/people/Jack--Cui/

|

||||

Modify:

|

||||

2017-08-28

|

||||

"""

|

||||

def gradAscent(dataMatIn, classLabels):

|

||||

dataMatrix = np.mat(dataMatIn) #转换成numpy的mat

|

||||

labelMat = np.mat(classLabels).transpose() #转换成numpy的mat,并进行转置

|

||||

m, n = np.shape(dataMatrix) #返回dataMatrix的大小。m为行数,n为列数。

|

||||

alpha = 0.01 #移动步长,也就是学习速率,控制更新的幅度。

|

||||

maxCycles = 500 #最大迭代次数

|

||||

weights = np.ones((n,1))

|

||||

weights_array = np.array([])

|

||||

for k in range(maxCycles):

|

||||

h = sigmoid(dataMatrix * weights) #梯度上升矢量化公式

|

||||

error = labelMat - h

|

||||

weights = weights + alpha * dataMatrix.transpose() * error

|

||||

weights_array = np.append(weights_array,weights)

|

||||

weights_array = weights_array.reshape(maxCycles,n)

|

||||

return weights.getA(),weights_array #将矩阵转换为数组,并返回

|

||||

|

||||

"""

|

||||

函数说明:改进的随机梯度上升算法

|

||||

|

||||

Parameters:

|

||||

dataMatrix - 数据数组

|

||||

classLabels - 数据标签

|

||||

numIter - 迭代次数

|

||||

Returns:

|

||||

weights - 求得的回归系数数组(最优参数)

|

||||

weights_array - 每次更新的回归系数

|

||||

Author:

|

||||

Jack Cui

|

||||

Blog:

|

||||

http://blog.csdn.net/c406495762

|

||||

Zhihu:

|

||||

https://www.zhihu.com/people/Jack--Cui/

|

||||

Modify:

|

||||

2017-08-31

|

||||

"""

|

||||

def stocGradAscent1(dataMatrix, classLabels, numIter=150):

|

||||

m,n = np.shape(dataMatrix) #返回dataMatrix的大小。m为行数,n为列数。

|

||||

weights = np.ones(n) #参数初始化

|

||||

weights_array = np.array([]) #存储每次更新的回归系数

|

||||

for j in range(numIter):

|

||||

dataIndex = list(range(m))

|

||||

for i in range(m):

|

||||

alpha = 4/(1.0+j+i)+0.01 #降低alpha的大小,每次减小1/(j+i)。

|

||||

randIndex = int(random.uniform(0,len(dataIndex))) #随机选取样本

|

||||

h = sigmoid(sum(dataMatrix[randIndex]*weights)) #选择随机选取的一个样本,计算h

|

||||

error = classLabels[randIndex] - h #计算误差

|

||||

weights = weights + alpha * error * dataMatrix[randIndex] #更新回归系数

|

||||

weights_array = np.append(weights_array,weights,axis=0) #添加回归系数到数组中

|

||||

del(dataIndex[randIndex]) #删除已经使用的样本

|

||||

weights_array = weights_array.reshape(numIter*m,n) #改变维度

|

||||

return weights,weights_array #返回

|

||||

|

||||

"""

|

||||

函数说明:绘制数据集

|

||||

|

||||

Parameters:

|

||||

weights - 权重参数数组

|

||||

Returns:

|

||||

无

|

||||

Author:

|

||||

Jack Cui

|

||||

Blog:

|

||||

http://blog.csdn.net/c406495762

|

||||

Zhihu:

|

||||

https://www.zhihu.com/people/Jack--Cui/

|

||||

Modify:

|

||||

2017-08-30

|

||||

"""

|

||||

def plotBestFit(weights):

|

||||

dataMat, labelMat = loadDataSet() #加载数据集

|

||||

dataArr = np.array(dataMat) #转换成numpy的array数组

|

||||

n = np.shape(dataMat)[0] #数据个数

|

||||

xcord1 = []; ycord1 = [] #正样本

|

||||

xcord2 = []; ycord2 = [] #负样本

|

||||

for i in range(n): #根据数据集标签进行分类

|

||||

if int(labelMat[i]) == 1:

|

||||

xcord1.append(dataArr[i,1]); ycord1.append(dataArr[i,2]) #1为正样本

|

||||

else:

|

||||

xcord2.append(dataArr[i,1]); ycord2.append(dataArr[i,2]) #0为负样本

|

||||

fig = plt.figure()

|

||||

ax = fig.add_subplot(111) #添加subplot

|

||||

ax.scatter(xcord1, ycord1, s = 20, c = 'red', marker = 's',alpha=.5)#绘制正样本

|

||||

ax.scatter(xcord2, ycord2, s = 20, c = 'green',alpha=.5) #绘制负样本

|

||||

x = np.arange(-3.0, 3.0, 0.1)

|

||||

y = (-weights[0] - weights[1] * x) / weights[2]

|

||||

ax.plot(x, y)

|

||||

plt.title('BestFit') #绘制title

|

||||

plt.xlabel('X1'); plt.ylabel('X2') #绘制label

|

||||

plt.show()

|

||||

|

||||

"""

|

||||

函数说明:绘制回归系数与迭代次数的关系

|

||||

|

||||

Parameters:

|

||||

weights_array1 - 回归系数数组1

|

||||

weights_array2 - 回归系数数组2

|

||||

Returns:

|

||||

无

|

||||

Author:

|

||||

Jack Cui

|

||||

Blog:

|

||||

http://blog.csdn.net/c406495762

|

||||

Zhihu:

|

||||

https://www.zhihu.com/people/Jack--Cui/

|

||||

Modify:

|

||||

2017-08-30

|

||||

"""

|

||||

def plotWeights(weights_array1,weights_array2):

|

||||

#设置汉字格式

|

||||

#font = FontProperties(fname=r"c:\windows\fonts\simsun.ttc", size=14)

|

||||

#将fig画布分隔成1行1列,不共享x轴和y轴,fig画布的大小为(13,8)

|

||||

#当nrow=3,nclos=2时,代表fig画布被分为六个区域,axs[0][0]表示第一行第一列

|

||||

fig, axs = plt.subplots(nrows=3, ncols=2,sharex=False, sharey=False, figsize=(20,10))

|

||||

x1 = np.arange(0, len(weights_array1), 1)

|

||||

#绘制w0与迭代次数的关系

|

||||

axs[0][0].plot(x1,weights_array1[:,0])

|

||||

axs0_title_text = axs[0][0].set_title(u'Improved Random Gradient Rising')

|

||||

axs0_ylabel_text = axs[0][0].set_ylabel(u'W0')

|

||||

plt.setp(axs0_title_text, size=20, weight='bold', color='black')

|

||||

plt.setp(axs0_ylabel_text, size=20, weight='bold', color='black')

|

||||

#绘制w1与迭代次数的关系

|

||||

axs[1][0].plot(x1,weights_array1[:,1])

|

||||

axs1_ylabel_text = axs[1][0].set_ylabel(u'W1')

|

||||

plt.setp(axs1_ylabel_text, size=20, weight='bold', color='black')

|

||||

#绘制w2与迭代次数的关系

|

||||

axs[2][0].plot(x1,weights_array1[:,2])

|

||||

axs2_xlabel_text = axs[2][0].set_xlabel(u'Iteration times')

|

||||

axs2_ylabel_text = axs[2][0].set_ylabel(u'W1')

|

||||

plt.setp(axs2_xlabel_text, size=20, weight='bold', color='black')

|

||||

plt.setp(axs2_ylabel_text, size=20, weight='bold', color='black')

|

||||

|

||||

|

||||

x2 = np.arange(0, len(weights_array2), 1)

|

||||

#绘制w0与迭代次数的关系

|

||||

axs[0][1].plot(x2,weights_array2[:,0])

|

||||

axs0_title_text = axs[0][1].set_title(u'Random Gradient Rising')

|

||||

axs0_ylabel_text = axs[0][1].set_ylabel(u'W0')

|

||||

plt.setp(axs0_title_text, size=20, weight='bold', color='black')

|

||||

plt.setp(axs0_ylabel_text, size=20, weight='bold', color='black')

|

||||

#绘制w1与迭代次数的关系

|

||||

axs[1][1].plot(x2,weights_array2[:,1])

|

||||

axs1_ylabel_text = axs[1][1].set_ylabel(u'W1')

|

||||

plt.setp(axs1_ylabel_text, size=20, weight='bold', color='black')

|

||||

#绘制w2与迭代次数的关系

|

||||

axs[2][1].plot(x2,weights_array2[:,2])

|

||||

axs2_xlabel_text = axs[2][1].set_xlabel(u'Iteration times')

|

||||

axs2_ylabel_text = axs[2][1].set_ylabel(u'W1')

|

||||

plt.setp(axs2_xlabel_text, size=20, weight='bold', color='black')

|

||||

plt.setp(axs2_ylabel_text, size=20, weight='bold', color='black')

|

||||

|

||||

plt.show()

|

||||

|

||||

if __name__ == '__main__':

|

||||

dataMat, labelMat = loadDataSet()

|

||||

weights1,weights_array1 = stocGradAscent1(np.array(dataMat), labelMat)

|

||||

|

||||

weights2,weights_array2 = gradAscent(dataMat, labelMat)

|

||||

plotWeights(weights_array1, weights_array2)

|

||||

|

|

@ -0,0 +1,193 @@

|

|||

#!/usr/bin/env python3

|

||||

# -*- coding:UTF-8 -*-

|

||||

from sklearn.linear_model import LogisticRegression

|

||||

import numpy as np

|

||||

import random

|

||||

|

||||

"""

|

||||

函数说明:sigmoid函数

|

||||

|

||||

Parameters:

|

||||

inX - 数据

|

||||

Returns:

|

||||

sigmoid函数

|

||||

Author:

|

||||

Jack Cui

|

||||

Blog:

|

||||

http://blog.csdn.net/c406495762

|

||||

Zhihu:

|

||||

https://www.zhihu.com/people/Jack--Cui/

|

||||

Modify:

|

||||

2017-09-05

|

||||

"""

|

||||

def sigmoid(inX):

|

||||

return 1.0 / (1 + np.exp(-inX))

|

||||

|

||||

"""

|

||||

函数说明:改进的随机梯度上升算法

|

||||

|

||||

Parameters:

|

||||

dataMatrix - 数据数组

|

||||

classLabels - 数据标签

|

||||

numIter - 迭代次数

|

||||

Returns:

|

||||

weights - 求得的回归系数数组(最优参数)

|

||||

Author:

|

||||

Jack Cui

|

||||

Blog:

|

||||

http://blog.csdn.net/c406495762

|

||||

Zhihu:

|

||||

https://www.zhihu.com/people/Jack--Cui/

|

||||

Modify:

|

||||

2017-09-05

|

||||

"""

|

||||

def stocGradAscent1(dataMatrix, classLabels, numIter=150):

|

||||

m,n = np.shape(dataMatrix) #返回dataMatrix的大小。m为行数,n为列数。

|

||||

weights = np.ones(n) #参数初始化 #存储每次更新的回归系数

|

||||

for j in range(numIter):

|

||||

dataIndex = list(range(m))

|

||||

for i in range(m):

|

||||

alpha = 4/(1.0+j+i)+0.01 #降低alpha的大小,每次减小1/(j+i)。

|

||||

randIndex = int(random.uniform(0,len(dataIndex))) #随机选取样本

|

||||

h = sigmoid(sum(dataMatrix[randIndex]*weights)) #选择随机选取的一个样本,计算h

|

||||

error = classLabels[randIndex] - h #计算误差

|

||||

weights = weights + alpha * error * dataMatrix[randIndex] #更新回归系数

|

||||

del(dataIndex[randIndex]) #删除已经使用的样本

|

||||

return weights #返回

|

||||

|

||||

|

||||

"""

|

||||

函数说明:梯度上升算法

|

||||

|

||||

Parameters:

|

||||

dataMatIn - 数据集

|

||||

classLabels - 数据标签

|

||||

Returns:

|

||||

weights.getA() - 求得的权重数组(最优参数)

|

||||

Author:

|

||||

Jack Cui

|

||||

Blog:

|

||||

http://blog.csdn.net/c406495762

|

||||

Zhihu:

|

||||

https://www.zhihu.com/people/Jack--Cui/

|

||||

Modify:

|

||||

2017-08-28

|

||||

"""

|

||||

def gradAscent(dataMatIn, classLabels):

|

||||

dataMatrix = np.mat(dataMatIn) #转换成numpy的mat

|

||||

labelMat = np.mat(classLabels).transpose() #转换成numpy的mat,并进行转置

|

||||

m, n = np.shape(dataMatrix) #返回dataMatrix的大小。m为行数,n为列数。

|

||||

alpha = 0.01 #移动步长,也就是学习速率,控制更新的幅度。

|

||||

maxCycles = 500 #最大迭代次数

|

||||

weights = np.ones((n,1))

|

||||

for k in range(maxCycles):

|

||||

h = sigmoid(dataMatrix * weights) #梯度上升矢量化公式

|

||||

error = labelMat - h

|

||||

weights = weights + alpha * dataMatrix.transpose() * error

|

||||

return weights.getA() #将矩阵转换为数组,并返回

|

||||

|

||||

|

||||

|

||||

"""

|

||||

函数说明:使用Python写的Logistic分类器做预测

|

||||

|

||||

Parameters:

|

||||

无

|

||||

Returns:

|

||||

无

|

||||

Author:

|

||||

Jack Cui

|

||||

Blog:

|

||||

http://blog.csdn.net/c406495762

|

||||

Zhihu:

|

||||

https://www.zhihu.com/people/Jack--Cui/

|

||||

Modify:

|

||||

2017-09-05

|

||||

"""

|

||||

def colicTest():

|

||||

frTrain = open('horseColicTraining.txt') #打开训练集

|

||||

frTest = open('horseColicTest.txt') #打开测试集

|

||||

trainingSet = []; trainingLabels = []

|

||||

for line in frTrain.readlines():

|

||||

currLine = line.strip().split('\t')

|

||||

lineArr = []

|

||||

for i in range(len(currLine)-1):

|

||||

lineArr.append(float(currLine[i]))

|

||||

trainingSet.append(lineArr)

|

||||

trainingLabels.append(float(currLine[-1]))

|

||||

trainWeights = stocGradAscent1(np.array(trainingSet), trainingLabels,500) #使用改进的随即上升梯度训练

|

||||

errorCount = 0; numTestVec = 0.0

|

||||

for line in frTest.readlines():

|

||||

numTestVec += 1.0

|

||||

currLine = line.strip().split('\t')

|

||||

lineArr =[]

|

||||

for i in range(len(currLine)-1):

|

||||

lineArr.append(float(currLine[i]))

|

||||

if int(classifyVector(np.array(lineArr), trainWeights))!= int(currLine[-1]):

|

||||

errorCount += 1

|

||||

errorRate = (float(errorCount)/numTestVec) * 100 #错误率计算

|

||||

print("测试集错误率为: %.2f%%" % errorRate)

|

||||

|

||||

"""

|

||||

函数说明:分类函数

|

||||

|

||||

Parameters:

|

||||

inX - 特征向量

|

||||

weights - 回归系数

|

||||

Returns:

|

||||

分类结果

|

||||

Author:

|

||||

Jack Cui

|

||||

Blog:

|

||||

http://blog.csdn.net/c406495762

|

||||

Zhihu:

|

||||

https://www.zhihu.com/people/Jack--Cui/

|

||||

Modify:

|

||||

2017-09-05

|

||||

"""

|

||||

def classifyVector(inX, weights):

|

||||

prob = sigmoid(sum(inX*weights))

|

||||

if prob > 0.5: return 1.0

|

||||

else: return 0.0

|

||||

|

||||

"""

|

||||

函数说明:使用Sklearn构建Logistic回归分类器

|

||||

|

||||

Parameters:

|

||||

无

|

||||

Returns:

|

||||

无

|

||||

Author:

|

||||

Jack Cui

|

||||

Blog:

|

||||

http://blog.csdn.net/c406495762

|

||||

Zhihu:

|

||||

https://www.zhihu.com/people/Jack--Cui/

|

||||

Modify:

|

||||

2017-09-05

|

||||

"""

|

||||

def colicSklearn():

|

||||

frTrain = open('horseColicTraining.txt') #打开训练集

|

||||

frTest = open('horseColicTest.txt') #打开测试集

|

||||

trainingSet = []; trainingLabels = []

|

||||

testSet = []; testLabels = []

|

||||

for line in frTrain.readlines():

|

||||

currLine = line.strip().split('\t')

|

||||

lineArr = []

|

||||

for i in range(len(currLine)-1):

|

||||

lineArr.append(float(currLine[i]))

|

||||

trainingSet.append(lineArr)

|

||||

trainingLabels.append(float(currLine[-1]))

|

||||

for line in frTest.readlines():

|

||||

currLine = line.strip().split('\t')

|

||||

lineArr =[]

|

||||

for i in range(len(currLine)-1):

|

||||

lineArr.append(float(currLine[i]))

|

||||

testSet.append(lineArr)

|

||||

testLabels.append(float(currLine[-1]))

|

||||

classifier = LogisticRegression(solver = 'sag',max_iter = 5000).fit(trainingSet, trainingLabels)

|

||||

test_accurcy = classifier.score(testSet, testLabels) * 100

|

||||

print('正确率:%f%%' % test_accurcy)

|

||||

|

||||

if __name__ == '__main__':

|

||||

colicSklearn()

|

||||

|

|

@ -0,0 +1,67 @@

|

|||

2 1 38.50 54 20 0 1 2 2 3 4 1 2 2 5.90 0 2 42.00 6.30 0 0 1

|

||||

2 1 37.60 48 36 0 0 1 1 0 3 0 0 0 0 0 0 44.00 6.30 1 5.00 1

|

||||

1 1 37.7 44 28 0 4 3 2 5 4 4 1 1 0 3 5 45 70 3 2 1

|

||||

1 1 37 56 24 3 1 4 2 4 4 3 1 1 0 0 0 35 61 3 2 0

|

||||

2 1 38.00 42 12 3 0 3 1 1 0 1 0 0 0 0 2 37.00 5.80 0 0 1

|

||||

1 1 0 60 40 3 0 1 1 0 4 0 3 2 0 0 5 42 72 0 0 1

|

||||

2 1 38.40 80 60 3 2 2 1 3 2 1 2 2 0 1 1 54.00 6.90 0 0 1

|

||||

2 1 37.80 48 12 2 1 2 1 3 0 1 2 0 0 2 0 48.00 7.30 1 0 1

|

||||

2 1 37.90 45 36 3 3 3 2 2 3 1 2 1 0 3 0 33.00 5.70 3 0 1

|

||||

2 1 39.00 84 12 3 1 5 1 2 4 2 1 2 7.00 0 4 62.00 5.90 2 2.20 0

|

||||

2 1 38.20 60 24 3 1 3 2 3 3 2 3 3 0 4 4 53.00 7.50 2 1.40 1

|

||||

1 1 0 140 0 0 0 4 2 5 4 4 1 1 0 0 5 30 69 0 0 0

|

||||

1 1 37.90 120 60 3 3 3 1 5 4 4 2 2 7.50 4 5 52.00 6.60 3 1.80 0

|

||||

2 1 38.00 72 36 1 1 3 1 3 0 2 2 1 0 3 5 38.00 6.80 2 2.00 1

|

||||

2 9 38.00 92 28 1 1 2 1 1 3 2 3 0 7.20 0 0 37.00 6.10 1 1.10 1

|

||||

1 1 38.30 66 30 2 3 1 1 2 4 3 3 2 8.50 4 5 37.00 6.00 0 0 1

|

||||

2 1 37.50 48 24 3 1 1 1 2 1 0 1 1 0 3 2 43.00 6.00 1 2.80 1

|

||||

1 1 37.50 88 20 2 3 3 1 4 3 3 0 0 0 0 0 35.00 6.40 1 0 0

|

||||

2 9 0 150 60 4 4 4 2 5 4 4 0 0 0 0 0 0 0 0 0 0

|

||||

1 1 39.7 100 30 0 0 6 2 4 4 3 1 0 0 4 5 65 75 0 0 0

|

||||

1 1 38.30 80 0 3 3 4 2 5 4 3 2 1 0 4 4 45.00 7.50 2 4.60 1

|

||||

2 1 37.50 40 32 3 1 3 1 3 2 3 2 1 0 0 5 32.00 6.40 1 1.10 1

|

||||

1 1 38.40 84 30 3 1 5 2 4 3 3 2 3 6.50 4 4 47.00 7.50 3 0 0

|

||||

1 1 38.10 84 44 4 0 4 2 5 3 1 1 3 5.00 0 4 60.00 6.80 0 5.70 0

|

||||

2 1 38.70 52 0 1 1 1 1 1 3 1 0 0 0 1 3 4.00 74.00 0 0 1

|

||||

2 1 38.10 44 40 2 1 3 1 3 3 1 0 0 0 1 3 35.00 6.80 0 0 1

|

||||

2 1 38.4 52 20 2 1 3 1 1 3 2 2 1 0 3 5 41 63 1 1 1

|

||||

1 1 38.20 60 0 1 0 3 1 2 1 1 1 1 0 4 4 43.00 6.20 2 3.90 1

|

||||

2 1 37.70 40 18 1 1 1 0 3 2 1 1 1 0 3 3 36.00 3.50 0 0 1

|

||||

1 1 39.1 60 10 0 1 1 0 2 3 0 0 0 0 4 4 0 0 0 0 1

|

||||

2 1 37.80 48 16 1 1 1 1 0 1 1 2 1 0 4 3 43.00 7.50 0 0 1

|

||||

1 1 39.00 120 0 4 3 5 2 2 4 3 2 3 8.00 0 0 65.00 8.20 3 4.60 1

|

||||

1 1 38.20 76 0 2 3 2 1 5 3 3 1 2 6.00 1 5 35.00 6.50 2 0.90 1

|

||||

2 1 38.30 88 0 0 0 6 0 0 0 0 0 0 0 0 0 0 0 0 0 0

|

||||

1 1 38.00 80 30 3 3 3 1 0 0 0 0 0 6.00 0 0 48.00 8.30 0 4.30 1

|

||||

1 1 0 0 0 3 1 1 1 2 3 3 1 3 6.00 4 4 0 0 2 0 0

|

||||

1 1 37.60 40 0 1 1 1 1 1 1 1 0 0 0 1 1 0 0 2 2.10 1

|

||||

2 1 37.50 44 0 1 1 1 1 3 3 2 0 0 0 0 0 45.00 5.80 2 1.40 1

|

||||

2 1 38.2 42 16 1 1 3 1 1 3 1 0 0 0 1 0 35 60 1 1 1

|

||||

2 1 38 56 44 3 3 3 0 0 1 1 2 1 0 4 0 47 70 2 1 1

|

||||

2 1 38.30 45 20 3 3 2 2 2 4 1 2 0 0 4 0 0 0 0 0 1

|

||||

1 1 0 48 96 1 1 3 1 0 4 1 2 1 0 1 4 42.00 8.00 1 0 1

|

||||

1 1 37.70 55 28 2 1 2 1 2 3 3 0 3 5.00 4 5 0 0 0 0 1

|

||||

2 1 36.00 100 20 4 3 6 2 2 4 3 1 1 0 4 5 74.00 5.70 2 2.50 0

|

||||

1 1 37.10 60 20 2 0 4 1 3 0 3 0 2 5.00 3 4 64.00 8.50 2 0 1

|

||||

2 1 37.10 114 40 3 0 3 2 2 2 1 0 0 0 0 3 32.00 0 3 6.50 1

|

||||

1 1 38.1 72 30 3 3 3 1 4 4 3 2 1 0 3 5 37 56 3 1 1

|

||||

1 1 37.00 44 12 3 1 1 2 1 1 1 0 0 0 4 2 40.00 6.70 3 8.00 1

|

||||

1 1 38.6 48 20 3 1 1 1 4 3 1 0 0 0 3 0 37 75 0 0 1

|

||||

1 1 0 82 72 3 1 4 1 2 3 3 0 3 0 4 4 53 65 3 2 0

|

||||

1 9 38.20 78 60 4 4 6 0 3 3 3 0 0 0 1 0 59.00 5.80 3 3.10 0

|

||||

2 1 37.8 60 16 1 1 3 1 2 3 2 1 2 0 3 0 41 73 0 0 0

|

||||

1 1 38.7 34 30 2 0 3 1 2 3 0 0 0 0 0 0 33 69 0 2 0

|

||||

1 1 0 36 12 1 1 1 1 1 2 1 1 1 0 1 5 44.00 0 0 0 1

|

||||

2 1 38.30 44 60 0 0 1 1 0 0 0 0 0 0 0 0 6.40 36.00 0 0 1

|

||||

2 1 37.40 54 18 3 0 1 1 3 4 3 2 2 0 4 5 30.00 7.10 2 0 1

|

||||

1 1 0 0 0 4 3 0 2 2 4 1 0 0 0 0 0 54 76 3 2 1

|

||||

1 1 36.6 48 16 3 1 3 1 4 1 1 1 1 0 0 0 27 56 0 0 0

|

||||

1 1 38.5 90 0 1 1 3 1 3 3 3 2 3 2 4 5 47 79 0 0 1

|

||||

1 1 0 75 12 1 1 4 1 5 3 3 0 3 5.80 0 0 58.00 8.50 1 0 1

|

||||

2 1 38.20 42 0 3 1 1 1 1 1 2 2 1 0 3 2 35.00 5.90 2 0 1

|

||||

1 9 38.20 78 60 4 4 6 0 3 3 3 0 0 0 1 0 59.00 5.80 3 3.10 0

|

||||

2 1 38.60 60 30 1 1 3 1 4 2 2 1 1 0 0 0 40.00 6.00 1 0 1

|

||||

2 1 37.80 42 40 1 1 1 1 1 3 1 0 0 0 3 3 36.00 6.20 0 0 1

|

||||

1 1 38 60 12 1 1 2 1 2 1 1 1 1 0 1 4 44 65 3 2 0

|

||||

2 1 38.00 42 12 3 0 3 1 1 1 1 0 0 0 0 1 37.00 5.80 0 0 1

|

||||

2 1 37.60 88 36 3 1 1 1 3 3 2 1 3 1.50 0 0 44.00 6.00 0 0 0

|

||||

|

|

@ -0,0 +1,299 @@

|

|||

2.000000 1.000000 38.500000 66.000000 28.000000 3.000000 3.000000 0.000000 2.000000 5.000000 4.000000 4.000000 0.000000 0.000000 0.000000 3.000000 5.000000 45.000000 8.400000 0.000000 0.000000 0.000000

|

||||

1.000000 1.000000 39.200000 88.000000 20.000000 0.000000 0.000000 4.000000 1.000000 3.000000 4.000000 2.000000 0.000000 0.000000 0.000000 4.000000 2.000000 50.000000 85.000000 2.000000 2.000000 0.000000

|

||||

2.000000 1.000000 38.300000 40.000000 24.000000 1.000000 1.000000 3.000000 1.000000 3.000000 3.000000 1.000000 0.000000 0.000000 0.000000 1.000000 1.000000 33.000000 6.700000 0.000000 0.000000 1.000000

|

||||

1.000000 9.000000 39.100000 164.000000 84.000000 4.000000 1.000000 6.000000 2.000000 2.000000 4.000000 4.000000 1.000000 2.000000 5.000000 3.000000 0.000000 48.000000 7.200000 3.000000 5.300000 0.000000

|

||||

2.000000 1.000000 37.300000 104.000000 35.000000 0.000000 0.000000 6.000000 2.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 74.000000 7.400000 0.000000 0.000000 0.000000

|

||||

2.000000 1.000000 0.000000 0.000000 0.000000 2.000000 1.000000 3.000000 1.000000 2.000000 3.000000 2.000000 2.000000 1.000000 0.000000 3.000000 3.000000 0.000000 0.000000 0.000000 0.000000 1.000000

|

||||

1.000000 1.000000 37.900000 48.000000 16.000000 1.000000 1.000000 1.000000 1.000000 3.000000 3.000000 3.000000 1.000000 1.000000 0.000000 3.000000 5.000000 37.000000 7.000000 0.000000 0.000000 1.000000

|

||||

1.000000 1.000000 0.000000 60.000000 0.000000 3.000000 0.000000 0.000000 1.000000 0.000000 4.000000 2.000000 2.000000 1.000000 0.000000 3.000000 4.000000 44.000000 8.300000 0.000000 0.000000 0.000000

|

||||

2.000000 1.000000 0.000000 80.000000 36.000000 3.000000 4.000000 3.000000 1.000000 4.000000 4.000000 4.000000 2.000000 1.000000 0.000000 3.000000 5.000000 38.000000 6.200000 0.000000 0.000000 0.000000

|

||||

2.000000 9.000000 38.300000 90.000000 0.000000 1.000000 0.000000 1.000000 1.000000 5.000000 3.000000 1.000000 2.000000 1.000000 0.000000 3.000000 0.000000 40.000000 6.200000 1.000000 2.200000 1.000000

|

||||

1.000000 1.000000 38.100000 66.000000 12.000000 3.000000 3.000000 5.000000 1.000000 3.000000 3.000000 1.000000 2.000000 1.000000 3.000000 2.000000 5.000000 44.000000 6.000000 2.000000 3.600000 1.000000

|

||||

2.000000 1.000000 39.100000 72.000000 52.000000 2.000000 0.000000 2.000000 1.000000 2.000000 1.000000 2.000000 1.000000 1.000000 0.000000 4.000000 4.000000 50.000000 7.800000 0.000000 0.000000 1.000000

|

||||

1.000000 1.000000 37.200000 42.000000 12.000000 2.000000 1.000000 1.000000 1.000000 3.000000 3.000000 3.000000 3.000000 1.000000 0.000000 4.000000 5.000000 0.000000 7.000000 0.000000 0.000000 1.000000

|

||||

2.000000 9.000000 38.000000 92.000000 28.000000 1.000000 1.000000 2.000000 1.000000 1.000000 3.000000 2.000000 3.000000 0.000000 7.200000 1.000000 1.000000 37.000000 6.100000 1.000000 0.000000 0.000000

|

||||

1.000000 1.000000 38.200000 76.000000 28.000000 3.000000 1.000000 1.000000 1.000000 3.000000 4.000000 1.000000 2.000000 2.000000 0.000000 4.000000 4.000000 46.000000 81.000000 1.000000 2.000000 1.000000

|

||||

1.000000 1.000000 37.600000 96.000000 48.000000 3.000000 1.000000 4.000000 1.000000 5.000000 3.000000 3.000000 2.000000 3.000000 4.500000 4.000000 0.000000 45.000000 6.800000 0.000000 0.000000 0.000000

|

||||

1.000000 9.000000 0.000000 128.000000 36.000000 3.000000 3.000000 4.000000 2.000000 4.000000 4.000000 3.000000 3.000000 0.000000 0.000000 4.000000 5.000000 53.000000 7.800000 3.000000 4.700000 0.000000

|

||||

2.000000 1.000000 37.500000 48.000000 24.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 1.000000

|

||||

1.000000 1.000000 37.600000 64.000000 21.000000 1.000000 1.000000 2.000000 1.000000 2.000000 3.000000 1.000000 1.000000 1.000000 0.000000 2.000000 5.000000 40.000000 7.000000 1.000000 0.000000 1.000000

|

||||

2.000000 1.000000 39.400000 110.000000 35.000000 4.000000 3.000000 6.000000 0.000000 0.000000 3.000000 3.000000 0.000000 0.000000 0.000000 0.000000 0.000000 55.000000 8.700000 0.000000 0.000000 1.000000

|

||||

1.000000 1.000000 39.900000 72.000000 60.000000 1.000000 1.000000 5.000000 2.000000 5.000000 4.000000 4.000000 3.000000 1.000000 0.000000 4.000000 4.000000 46.000000 6.100000 2.000000 0.000000 1.000000

|

||||

2.000000 1.000000 38.400000 48.000000 16.000000 1.000000 0.000000 1.000000 1.000000 1.000000 3.000000 1.000000 2.000000 3.000000 5.500000 4.000000 3.000000 49.000000 6.800000 0.000000 0.000000 1.000000

|

||||

1.000000 1.000000 38.600000 42.000000 34.000000 2.000000 1.000000 4.000000 0.000000 2.000000 3.000000 1.000000 0.000000 0.000000 0.000000 1.000000 0.000000 48.000000 7.200000 0.000000 0.000000 1.000000

|

||||

1.000000 9.000000 38.300000 130.000000 60.000000 0.000000 3.000000 0.000000 1.000000 2.000000 4.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 50.000000 70.000000 0.000000 0.000000 1.000000

|

||||

1.000000 1.000000 38.100000 60.000000 12.000000 3.000000 3.000000 3.000000 1.000000 0.000000 4.000000 3.000000 3.000000 2.000000 2.000000 0.000000 0.000000 51.000000 65.000000 0.000000 0.000000 1.000000

|

||||

2.000000 1.000000 37.800000 60.000000 42.000000 0.000000 0.000000 0.000000 1.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 1.000000

|

||||

1.000000 1.000000 38.300000 72.000000 30.000000 4.000000 3.000000 3.000000 2.000000 3.000000 3.000000 3.000000 2.000000 1.000000 0.000000 3.000000 5.000000 43.000000 7.000000 2.000000 3.900000 1.000000

|

||||

1.000000 1.000000 37.800000 48.000000 12.000000 3.000000 1.000000 1.000000 1.000000 0.000000 3.000000 2.000000 1.000000 1.000000 0.000000 1.000000 3.000000 37.000000 5.500000 2.000000 1.300000 1.000000

|

||||

1.000000 1.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000

|

||||

2.000000 1.000000 37.700000 48.000000 0.000000 2.000000 1.000000 1.000000 1.000000 1.000000 1.000000 1.000000 1.000000 1.000000 0.000000 0.000000 0.000000 45.000000 76.000000 0.000000 0.000000 1.000000

|

||||

2.000000 1.000000 37.700000 96.000000 30.000000 3.000000 3.000000 4.000000 2.000000 5.000000 4.000000 4.000000 3.000000 2.000000 4.000000 4.000000 5.000000 66.000000 7.500000 0.000000 0.000000 0.000000

|

||||

2.000000 1.000000 37.200000 108.000000 12.000000 3.000000 3.000000 4.000000 2.000000 2.000000 4.000000 2.000000 0.000000 3.000000 6.000000 3.000000 3.000000 52.000000 8.200000 3.000000 7.400000 0.000000

|

||||

1.000000 1.000000 37.200000 60.000000 0.000000 2.000000 1.000000 1.000000 1.000000 3.000000 3.000000 3.000000 2.000000 1.000000 0.000000 4.000000 5.000000 43.000000 6.600000 0.000000 0.000000 1.000000

|

||||

1.000000 1.000000 38.200000 64.000000 28.000000 1.000000 1.000000 1.000000 1.000000 3.000000 1.000000 0.000000 0.000000 0.000000 0.000000 4.000000 4.000000 49.000000 8.600000 2.000000 6.600000 1.000000

|

||||

1.000000 1.000000 0.000000 100.000000 30.000000 3.000000 3.000000 4.000000 2.000000 5.000000 4.000000 4.000000 3.000000 3.000000 0.000000 4.000000 4.000000 52.000000 6.600000 0.000000 0.000000 1.000000

|

||||

2.000000 1.000000 0.000000 104.000000 24.000000 4.000000 3.000000 3.000000 2.000000 4.000000 4.000000 3.000000 0.000000 3.000000 0.000000 0.000000 2.000000 73.000000 8.400000 0.000000 0.000000 0.000000

|

||||

2.000000 1.000000 38.300000 112.000000 16.000000 0.000000 3.000000 5.000000 2.000000 0.000000 0.000000 1.000000 1.000000 2.000000 0.000000 0.000000 5.000000 51.000000 6.000000 2.000000 1.000000 0.000000

|

||||

1.000000 1.000000 37.800000 72.000000 0.000000 0.000000 3.000000 0.000000 1.000000 5.000000 3.000000 1.000000 0.000000 1.000000 0.000000 1.000000 1.000000 56.000000 80.000000 1.000000 2.000000 1.000000

|

||||

2.000000 1.000000 38.600000 52.000000 0.000000 1.000000 1.000000 1.000000 1.000000 3.000000 3.000000 2.000000 1.000000 1.000000 0.000000 1.000000 3.000000 32.000000 6.600000 1.000000 5.000000 1.000000

|

||||

1.000000 9.000000 39.200000 146.000000 96.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000

|

||||

1.000000 1.000000 0.000000 88.000000 0.000000 3.000000 3.000000 6.000000 2.000000 5.000000 3.000000 3.000000 1.000000 3.000000 0.000000 4.000000 5.000000 63.000000 6.500000 3.000000 0.000000 0.000000

|

||||

2.000000 9.000000 39.000000 150.000000 72.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 0.000000 47.000000 8.500000 0.000000 0.100000 1.000000

|

||||

2.000000 1.000000 38.000000 60.000000 12.000000 3.000000 1.000000 3.000000 1.000000 3.000000 3.000000 1.000000 1.000000 1.000000 0.000000 2.000000 2.000000 47.000000 7.000000 0.000000 0.000000 1.000000

|

||||

1.000000 1.000000 0.000000 120.000000 0.000000 3.000000 4.000000 4.000000 1.000000 4.000000 4.000000 4.000000 1.000000 1.000000 0.000000 0.000000 5.000000 52.000000 67.000000 2.000000 2.000000 0.000000

|

||||

1.000000 1.000000 35.400000 140.000000 24.000000 3.000000 3.000000 4.000000 2.000000 4.000000 4.000000 0.000000 2.000000 1.000000 0.000000 0.000000 5.000000 57.000000 69.000000 3.000000 2.000000 0.000000

|

||||

2.000000 1.000000 0.000000 120.000000 0.000000 4.000000 3.000000 4.000000 2.000000 5.000000 4.000000 4.000000 1.000000 1.000000 0.000000 4.000000 5.000000 60.000000 6.500000 3.000000 0.000000 0.000000

|

||||

1.000000 1.000000 37.900000 60.000000 15.000000 3.000000 0.000000 4.000000 2.000000 5.000000 4.000000 4.000000 2.000000 2.000000 0.000000 4.000000 5.000000 65.000000 7.500000 0.000000 0.000000 1.000000